Python

Python 【Python】pandasのread_csvがkilledで止まるときの対処法

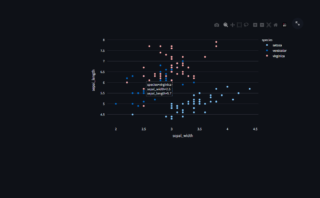

vpnサーバーなどでpandasでcsvを読み込むときにcsvのサイズが大きすぎると「killed」と表示され、実行プロセスが勝手に終了してしまうことがあります。今日はその場合の対処法について自分が行っているアプローチをメモしておき...

Python

Python  Python

Python  Selenium

Selenium  Web技術

Web技術  Python

Python  Python

Python  Python

Python  Python

Python  Python

Python  プログラミング

プログラミング